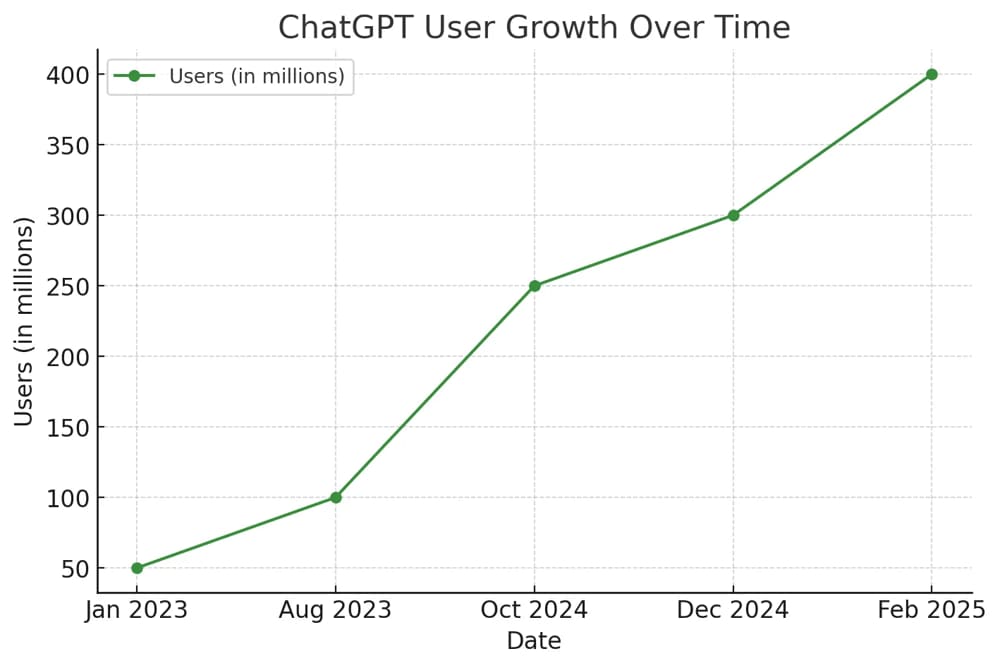

人工智能特别是自然语言处理(NLP)的发展日新月异,ChatGPT 4.0 的横空出世更是引发了新一轮技术浪潮。越来越多的企业、开发者、研究人员希望训练属于自己的ChatGPT模型,以实现更贴合业务需求的个性化AI对话系统。但在真正动手之前,你必须了解训练GPT 4.0模型背后的五个关键步骤。

本文将从准备数据到部署上线,全流程解析打造专属 ChatGPT 4.0 的实操路径。

第一步:明确模型用途与目标

训练一个 ChatGPT 模型并非“点几下按钮”就能完成的任务,它需要清晰的目标设定。

1.1 为什么需要自训练模型?

-

通用版ChatGPT虽然强大,但对行业术语、企业知识、专业对话掌握不够深入。

-

私有化部署可保护企业数据隐私与安全。

-

用户希望拥有更强的掌控力和可扩展性。

1.2 明确使用场景

你训练模型是用于:

-

客服机器人?

-

专业写作助手?

-

医疗、法律、金融等垂直行业问答?

-

编程助手或教育类互动工具?

明确目标,将直接影响你后续的数据选择、训练策略、资源配置。

ChatGPT账号价格表

第二步:收集和准备高质量训练数据

训练语言模型的核心是数据质量,而不是模型大小。

2.1 选择数据类型

-

对话数据:适合问答、聊天、任务型对话系统。

-

文档数据:适合知识学习类模型,如FAQ、行业白皮书。

-

代码数据:用于开发编程类助手。

2.2 数据来源

-

自有企业文档

-

客户服务聊天记录

-

开源数据集(如:OpenWebText、Common Crawl、The Pile)

-

网络爬虫工具(注意遵守版权法规)

2.3 数据清洗与格式化

数据预处理是训练效果好坏的分水岭:

-

去重、去乱码、统一编码

-

标准化问答结构(如将用户问题与AI回答配对)

-

避免包含敏感、违法、低质量内容

可以使用工具如:Python + Pandas、Regex、LangChain + OpenAI Embeddings 进行预处理。

第三步:选择训练方式与模型架构

3.1 使用预训练模型微调(Fine-tuning)

这是目前性价比最高的方式:

OpenAI、Hugging Face、Mistral、Anthropic等均开放了部分预训练模型供二次开发使用。你可以基于这些基础模型,在你的特定数据集上进行微调。

优点:

-

不需要从头训练,节省时间和成本

-

微调后的模型更贴合实际场景

-

更适合中小企业和个人开发者

3.2 使用LoRA、QLoRA等高效训练技术

这类方法只训练部分模型参数,适用于低资源环境。

-

LoRA(Low Rank Adaptation):显著降低计算需求,适合快速迭代。

-

QLoRA:结合量化技术与LoRA,进一步降低显存占用,适合消费级GPU(如RTX 3090/4090)。

推荐框架:Hugging Face Transformers + PEFT + bitsandbytes

3.3 模型选择参考

| 模型名称 | 参数量 | 说明 |

|---|---|---|

| GPT-2 | 1.5B | 入门级微调 |

| LLaMA-2 7B | 7B | Hugging Face支持,社区资源丰富 |

| Mistral 7B | 7B | 开源界黑马,支持高效推理 |

| GPT-4(API) | 商业闭源 | 不能本地训练,但可通过 API 接入 |

第四步:模型训练与评估

4.1 训练前配置

-

硬件设备:建议使用至少一块 A100 / 3090 / 4090 显卡,或租用云服务(如 AWS Sagemaker、Lambda Labs、RunPod)。

-

框架支持:推荐 PyTorch + Hugging Face Transformers。

-

分布式训练:当参数量过大时,可用 DeepSpeed、FSDP 进行加速。

4.2 训练过程监控

使用工具如:

-

WandB(Weights & Biases)

-

TensorBoard

-

MLflow

你可以实时追踪 loss 曲线、验证集表现、token使用率等。

4.3 评估指标

-

Perplexity:衡量模型困惑度,越低越好

-

BLEU / ROUGE:适合文本生成任务的匹配度评估

-

GPT-4 Eval:可使用 GPT-4 对比原始输出与微调后的结果做评判

建议每训练完一轮就评估一次,及时调参优化。

第五步:模型部署与上线优化

训练只是开始,真正应用才是价值所在。

5.1 部署方式

-

本地部署:适合数据敏感场景(推荐使用 vLLM、Text Generation WebUI)

-

云端部署:如 AWS、GCP、Azure 部署 API 接口,易于扩展

-

容器化部署:用 Docker + Kubernetes 实现弹性负载

5.2 构建聊天接口

-

使用 Gradio、Streamlit 快速搭建 Web Demo

-

用 FastAPI、Flask 构建后端 API,集成至业务系统中

5.3 安全策略

-

实施内容过滤(如加入 profanity-checker、敏感词过滤器)

-

加入用户身份校验与访问控制

-

支持 API 请求限流与日志记录

5.4 持续优化与反馈机制

-

日志记录用户提问与模型回答,进行分析迭代

-

收集用户反馈,优化提示词(Prompt Engineering)

-

可结合 RAG(检索增强生成)提升回答准确率

附加建议:是否真的需要“自己训练”?

如果你只是希望让模型了解你的业务知识,而不是大规模训练整个模型,可以考虑:

✔ 使用 RAG(Retrieval-Augmented Generation)

通过将知识库嵌入向量空间,结合 OpenAI API 实现“语义问答”,无需微调。

✔ 使用 ChatGPT 自定义助手(OpenAI GPTs)

可通过简易设置和文件上传,自定义一个专属 ChatGPT 实体。

✔ 使用 Hugging Face Spaces + LLM API 搭建原型

快速试验产品逻辑与AI交互效果。

这些方法无需GPU训练资源,适合中小团队与初创项目。

总结:打造专属ChatGPT模型的5个关键步骤

1️⃣ 明确使用目标与业务场景

2️⃣ 收集清洗高质量训练数据

3️⃣ 选择合适的模型和训练方式(微调 vs LoRA)

4️⃣ 科学训练并评估模型性能

5️⃣ 成功部署并持续优化

训练自己的 ChatGPT 4.0 虽然是一个复杂工程,但借助开源工具与社区资源,只要思路清晰、数据扎实,个人或小团队也完全可以打造高质量的智能对话系统。

📌 常见问题 FAQ

Q1:ChatGPT 4.0是开源的吗?

目前GPT-4本体未开源,但有很多性能接近的开源模型,如Mistral、LLaMA、Mixtral等可供训练和部署。

Q2:我可以直接训练一个像GPT-4那样的模型吗?

理论上可以,但需要庞大的算力资源(数千万美元级别)。推荐从开源基础模型微调起步。

Q3:训练一个私有模型的最低成本大约是多少?

如果使用QLoRA+LoRA技术,在消费级显卡(如RTX 3090)上训练,最低成本可控制在数百美元以内。

暂无评论内容